File - a megfelelő beállítást az index a helyszínen Yandex és google

Az első dolog, hogy a kereső bot, hogy jön a helyszínen, keresi és olvassa be a robots.txt fájlt. Mi a robots.txt fájl - egy sor utasítást a kereső. Ez egy szöveges fájl, amely található a gyökérkönyvtárban egy oldalon. Ez a fájl jelzi a bejáró index az oldalon, és mi nem. Csak azt mutatják, a fő tükör a helyén, és hol kell keresni a site map.

Miért van szükség egy robots.txt fájlt? A megfelelő webhely indexelése. Bármi legyen is az elváltozást nem ismétlődő oldalak, a különböző oldalak és az irodai dokumentumok. Ha megfelelően konfigurálja a robots.txt fájlban akkor mentse a webhely sok probléma indexelés és zazerkalivaniem oldalon.

Hogyan készítsünk egy helyes robots.txt

Robots.txt létrehozása nagyon könnyen, hozzon létre egy szöveges dokumentumot a Jegyzettömb a Windows. Írás a fájl irányelvek a keresőmotorok. Ezután mentse a fájlt néven «robotok» vagy szöveges bővítése. Minden most már lehet kitölteni otthont gyökérmappájába az oldalon. Felhívjuk figyelmét, hogy csak egy robots.txt létre lehet hozni egy telephelyen. Ha ez a fájl nem áll rendelkezésre a helyszínen, akkor a bot automatikusan „dönt”, hogy lehet indexelni.

Mivel ő az egyik, akkor ott vannak írásos utasításokat minden keresőmotorok. És ez felírható külön utasítást minden alállomás és az általános jobbra alatta. Elkülönítése utasításokat a különböző kereső robotok keresztül történik a User-agent irányelvet. Mi még beszélni erről később.

robots.txt irányelvek

A robots.txt fájl az alábbi irányelveket, hogy ellenőrizzék az indexelés: User-agent, elutasítás, engedélyezése, Sitemap, fogadó Crawl-delay, Clean-param. Nézzük az egyes utasításokat részletesen.

User-agent irányelv

User-agent irányelv - pont olyan utasításokat (vagy inkább egy adott bot), hogy a kereső. Ha van egy „*”, akkor az utasítások az összes robot. Ha megad egy speciális robot, például Googlebot, akkor az utasítások kizárólag a Google fő indexelő robot. És ha vannak utasítások és külön Googlebot és az összes többi tagállam, a Google csak olvasható kézikönyvek és általános figyelmen kívül hagyásával. Yandex bot nem ugyanaz. A példákat lásd a felvételt az irányelvet.

User-agent: YandexBot - az utasítások az alap indexelés bot Yandex

User-agent: Yandex - utasítások minden Yandex bot

User-agent: * - utasítások az összes botok

Letiltása és engedélyezése irányelvek

Irányelv tiltása és engedélyezése - lehetővé teszi a csapatot, hogy egy index, és mi nem. Tiltása utasítja, hogy ne index egy oldalt vagy egy része a helyszínen. A Hagyjuk ellenkezőleg azt jelzi, hogy az indexelni kívánt.

Disallow: / - megtiltja index az egész oldalon

Disallow: / PAPKA / - megtiltja az index minden tartalmát egy mappába

Tiltása: /files.php - megtiltja files.php index fájl

Engedélyezés: / cgi-bin - lehetővé teszi index oldalak cgi-bin

A tiltása és engedélyezése irányelvek lehetnek, és gyakran csak meg kell használni speciális karaktereket. Meg kell határozni a reguláris kifejezéseket.

Különleges karakterek * - helyettesít bármilyen karaktersor. Ő tulajdonított az alapértelmezett, hogy a végén minden szabályt. Még ha nem regisztrált, az SS maguk a végrehajtók. Használati példa:

Tiltása: /cgi-bin/*.aspx - tiltja index minden kiterjesztésű fájlok .aspx

Disallow: / * foto - megtiltják indexelése fájlok és mappák szót tartalmazó foto

Különleges karakterek $ - törli a joker „*” a végén a szabályokat. Például:

Disallow: / pl $ - megtiltja az index '/ example', de nem tiltja '/example.html'

És ha $ előírják az utasítást munka nélkül helyettesítő már más a helyzet:

Disallow: / példa -, és megtiltja a '/ example' és '/example.html'

Sitemap irányelv

Sitemap irányelv - célja, hogy jelezze a robot kereső, milyen helyen van egy ellenséges telek térképet. oldaltérkép méret legyen sitemaps.xml. Sitemap szükség gyorsabb és teljesebb webhely indexelése. És az oldal térkép nem feltétlenül egyetlen fájl, lehet, hogy több. Irányelvek Felvételi formátum:

Sitemap: /sitemaps1.xml

Sitemap: /sitemaps2.xml

host irányelv

Irányelv Host - jelzi a robot fő tükör oldalon. Hogy nem volt tükör az index oldalon, mindig adja meg ezt az irányelvet. Ha ez nem jelenti azt, Yandex robot index legalább két változata a webhely és anélkül www. Míg zerkalschik robot nincsenek ragasztva. Példa bejegyzések:

Host: www.seob.info

Host: seob.info

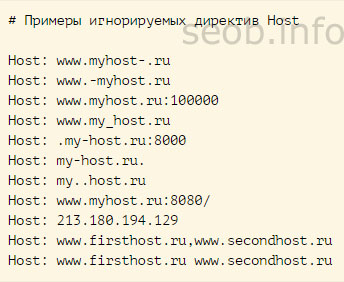

Az első esetben, a robot index a változat www, a második esetben nem. Írhat fel gyógyszert csak egy fogadó irányelv robots.txt. Ha a lista azok száma, akkor a bot fogja feldolgozni és tudomásul fogja venni az csak az első.

Nem megfelelően tett az irányelv által egyszerűen figyelmen kívül hagyja.

Crawl-delay irányelv

Crawl-delay irányelv csökkenti a terhelést a szerveren. Erre azért van szükség abban az esetben a weboldal kezd menni a támadás a különböző botok. Crawl-delay irányelv meghatározza a keresőrobotja várakozási idő vége között injekcióval egy oldal, és az elején injekciót a másik oldalt a webhelyen. Az irányelv jöjjön azonnal az irányelvek bejegyzések «tiltása» és / vagy «engedélyezése». Yandex kereső robot használt olvasni tört értékeket. Például: 1,5 (fél másodpercig).

Clean-param irányelv

Clean-param irányelv kívánt helyre, az oldalakon, amelyek dinamikus paramétereket. Beszélünk azok, amelyek nem befolyásolják a tartalmát oldalakon. Ez egy másik szolgáltatás információk: Session azonosítók, használati, hivatkozó stb Annak érdekében, hogy nem lenne megismételni ezeket az oldalakat, és használja ezt az irányelvet. Azt mondja, az MS nem lehet újra feltölteni az információkat kap. És csökkenti a terhelést a szerveren, és míg mászó robot oldalon.

Clean-param: s /forum/showthread.php

Ez a bejegyzés azt mondja, hogy a PS s paraméter nem tekinthető jelentősnek minden url Nem, kezdje /forum/showthread.php. A maximális felvételi hossza 500 karakter.

Az irányelvek érteni, folytassa a mi megszokott robotok fájlba.

Beállítás robots.txt

Elindíthatja a telepítést a robots.txt fájl. Ennek tartalmaznia kell legalább két bejegyzést:

User-agent: - pont, hogy a kereső is fut az alábbi utasításokat.

Tiltása: - meghatározza, hogy mely része a helyszínen nincs indexelve. Kiterjedhet az indexelést, mint egy oldal oldalon, vagy a teljes szakaszok.

És lehetséges, rámutatni arra, hogy ezeket az irányelveket szánt minden kereső, vagy bármely különös. Jelölje meg ezt a User-agent irányelvet. Ha azt szeretnénk, hogy olvassa el az utasításokat minden bot - tegye a „csillag”

Ha szeretne regisztrálni utasításokat adott robot, de meg kell adnunk a nevet.

Az egyszerűsített példa a helyes robots.txt fájl így néz ki:

User-agent: *

Letiltás: /files.php

Disallow: / razdel /

Host: seob.info

Ha * azt mondja, hogy az utasítások az összes alállomások;

Tiltása: /files.php - biztosítja a tilalmat file.php fájlindexelés;

Disallow: / foto / - megtiltja indexelése az egész az egész szakasz «foto» az összes berendezés;

Host: seob.info - azt jelzi, robotok, amelyek index a tükörben.

Ha nincsenek oldalak a helyszínen, hogy szükség van, hogy állítsa le az indexelést, akkor a robots.txt fájlt kell:

User-agent: *

Letiltás:

Host: seob.info

Robots.txt Yandex (Yandex)

Ez azt jelzi, hogy ezek az utasítások a kereső Yandex, szükséges előírni az irányelvben User-agent: Yandex. És ha írunk «Yandex» a helyén lesz index minden robotot Yandex, és ha mi azt jelzik «YandexBot» - ez lesz a csapat csak az elsődleges indexelő robot.

Valamint meg kell felírni az irányelv «fogadó», amely meghatározza az elsődleges tükör oldalon. Mint korábban írtam, ez azért van szükség, hogy elkerüljék ismétlődő oldalakat. A jobb robots.txt Yandex van:

User-agent: Yandex

Disallow: / cgi-bin

Disallow: / adminka

Host: seob.info

Sitemap: /sitemaps.xml

Eddig gyakran hallani kérdésekre, akkor jobb, ha meghatározza a fogadó az irányelvben, a helyszín vagy anélkül www. De nincs különbség. Itt egyszerűen, ahogy tetszik, hogy az oldal nézne kiadni egy PS. Fontos ne felejtsük el megadni azt is, ami nem ismétlődések.

Robots.txt Google

Google kereső támogatja az összes elterjedt robots.txt fájl felvételi formátumok. Igaz, ő nem tartja a fogadó irányelvet. Ezért különbségek Yandex ténylegesen nem. Robots.txt a Google a következő lesz:

User-agent: Googlebot

Disallow: / cgi-bin

Disallow: / adminka

Sitemap: /sitemaps.xml

Remélem, hogy az információt, amit meghatározott lesz elég ahhoz, hogy jó minőségű, és ami a legfontosabb a megfelelő fájlt. robots.txt. Ha használja az egyik legnépszerűbb CMS A következő cikkben, én már készen van a válogatott Robots - robots.txt népszerű CMS